要问今年最大的热点是什么?AI说第二,没人敢说自己是第一,这年头谁若是没用过ChatGPT提升下自己的生产力,都不敢称自己是合格的打工人。

不仅是个人的日常工作,生成式AI更是为许多行业带来了突破性的变革,近年来其使用量呈指数级增长。因此,全球领先的科技公司如OpenAI、微软、谷歌和亚马逊,正在乘势加速推动AI的发展。

然而,AI盛世之下却埋藏能源危机:AI使用量的爆发式增长,带来了惊人的耗电量,这些公司以及所在国家的碳净零目标面临着巨大挑战。

为了给AI数据中心提供清洁的电力能源,巨头公司纷纷出手:

- 亚马逊已成为全球最大的可再生能源购买者;

- 谷歌也已签署了史上最大的可再生能源协议;

- 微软正寻求开发自己的核电站;

但许多人认为这些还远远不够......

国际能源署(IEA):全球数据中心的耗电量到2026年将达到1,000TWh。AI带来的数据中心耗电量增长速度正超过全球可再生能源容量的增长速度,然而许多西方国家正规划的法规将限制额外的可再生能源容量建设。

彭博社(Bloomberg):到2030年,AI造成的耗电量将超过全球除12个国家以外的所有耗电量 。

因此,为尽可能地减少耗电量,提升用电效率成为了的重要切入点。在整个数据中心系统中,处理器、冷却系统和电源分别是三个最大耗电点。

将目光聚焦到其中之一的电源,业里制定了一些电源效率规范,其中著名的是80 PLUS。这个标准虽然是自愿性的,然而,80 PLUS中的钛金级效率标准已被欧盟采纳,作为其生态设计标准,并强制要求在欧盟运营的AI数据中心采用符合此效率标准的电源。钛金级标准规定电源(PSU)的效率为96%。

AI数据中心耗电量的持续增长,要求使用CRPS或OCP这种固定标准外形电源具备更高的功率密度。

采用CRPS和OCP固定标准外形的服务器电源

目前,硅还是电源里主要的半导体材料,但下一代AI所需电源的性能和效率要求正逐步超出硅的性能极限。因此,电源行业将目光逐渐转到宽禁带材料上:如碳化硅(SiC)和氮化镓(GaN),以尽可能有效地满足运算需求。

AI数据中心究竟会有多耗电?

在解答这个问题之前,我们先了解下当下的情况:

由于AI的增长,数据中心的耗电量正在迅速上升:

国际能源署(IEA):仅在2022年,全球数据中心就消耗了大约460TWh的电力,约占全球发电量的2%。在美国,2023年度的数据中心耗电量占全美的3%。

如前面所提到的,增长的耗电量对国家/公司的碳净零目标带来挑战,一些地区/国家正在对新开发项目实施更严格的规划限制。因此,许多公司正在寻找替代能源,包括对可再生能源的投资和建设小型核设施来为他们的AI数据中心供电。

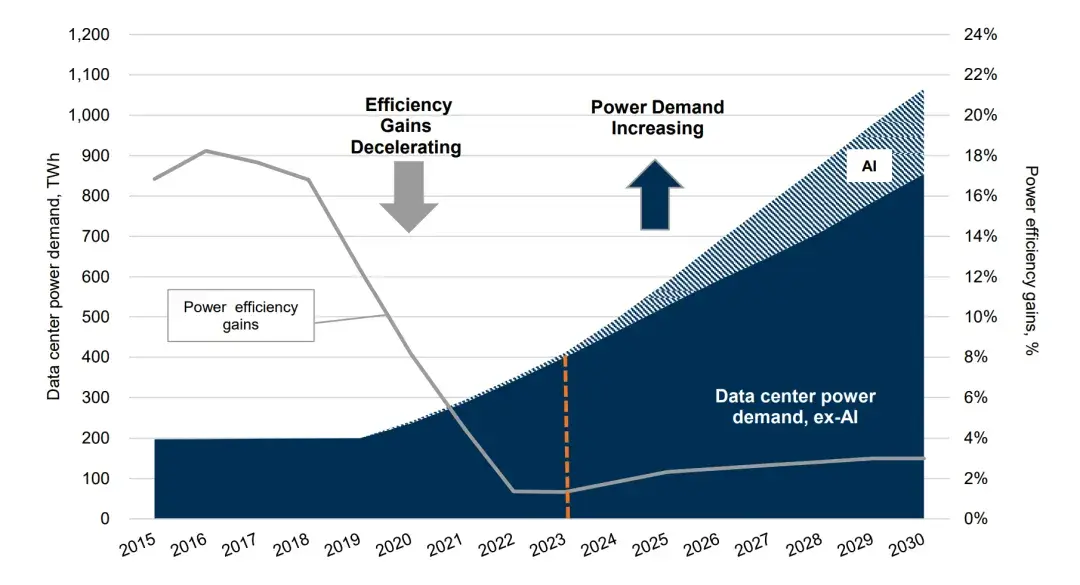

尽管AI还未进入大规模应用,但数据中心电力消耗的大幅增长已是大势所趋,同时每年的能效提升率也不容乐观:已从2016年的约18%放缓至2023年的约1%。

来自高盛的报告,数据中心耗电量由于AI使用率提升而增加,但能效提升率放缓

放眼未来,数据中心耗电量即将迎来爆发增长已经成为了全球共识。

国际能源署(IEA):到2026年,全球数据中心的耗电量可能超过1000TWh。而四年后仅美国的数据中心耗电量就能达到这个数字;

高盛(Goldman Sachs):在2020-2030的十年间,数据中心的电力消耗将增加超过两倍,达到约8%,并将电力需求的加速增长主要归因于AI。

瑞典预计到2030年,由于AI的影响,数据中心的耗电量将翻倍,并在2040年再次翻倍。在英国,预计未来十年内,AI数据中心的耗电量将增长超过5倍。

彭博社(Bloomberg):目前全球正在建设或已经建成的数据中心超过7000个,这一数字在2015年仅为3600。到2034年,全球数据中心的耗电量将大致与整个印度的耗电量相当。

AI数据中心耗电量增长也源于用户逐渐转向使用生成式AI搜索引擎,与传统谷歌搜索相比,ChatGPT的耗电量在前者的6到10倍之间。

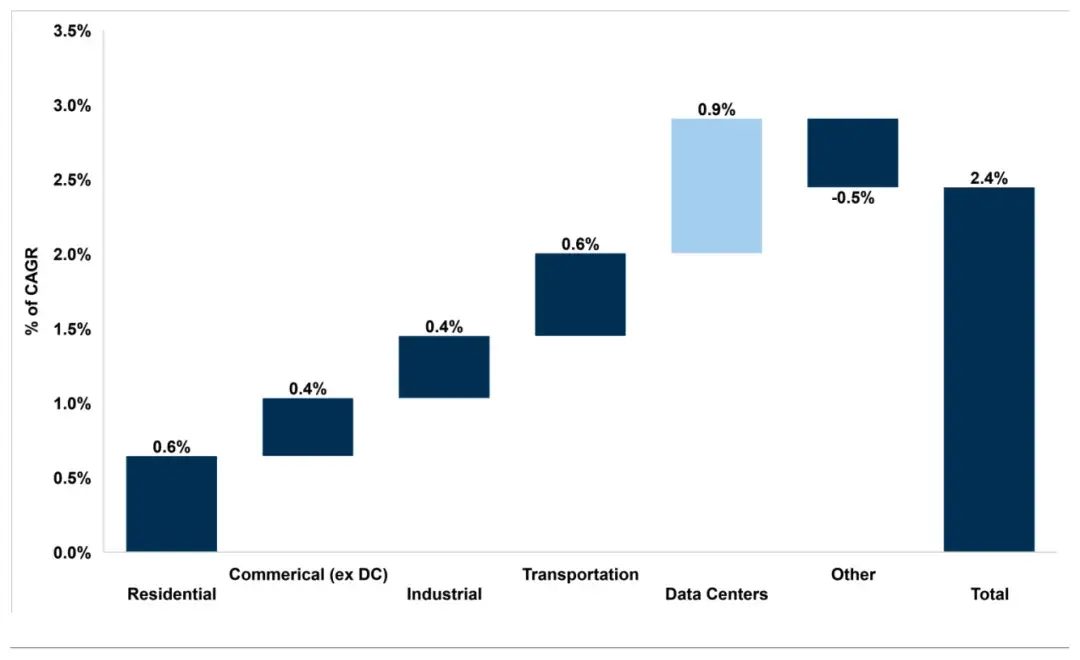

当合其他预计在2022年到2030年间,美国电力需求的复合年增长率(CAGR)为2.4%。根据高盛(Goldman Sachs)的一份报告显示,AI数据中心的耗电量增长将是所有在追踪行业中最高的,贡献了0.9个百分点(占总增长的38%),这比其他两个最大的耗电量增长领域:住宅(0.6个百分点)和交通(0.6个百分点)多出50%。

来自高盛的报告,AI数据中心耗电量为所有行业最高

AI芯片及其功耗的演进

AI数据中心为什么这么耗电?AI芯片日益恐怖的算力可谓是当之无愧的主要原因。为了让大家更好了解到算力和耗电量之间的关系,我们决定为大家梳理下AI芯片的进化史:

AI芯片早期发展——2015年之前

在AI发展的早期,运算都是在标准GPU上进行的,而不是专用GPU硬件。典型的例子:

AMD FirePro S9150:于2014年推出,在发布时被称为“HPC(高性能计算)最强大的服务器GPU”,可提供5.07万亿次浮点运算能力,功耗为235W

NVIDIA CUDA支持型Tesla K80:于2014年推出,用于深度学习,可提供8.73万亿次浮点运算能力,功耗为300W

AI进化期——2015-2019

这一时期在推进机器学习和人工智能应用方面奠定了基础,专门为AI开发了处理器。例子包括:

NVIDIA Tesla v100:于2017年推出,可提供125万亿次浮点运算能力,功耗为300W

Google Tensor处理单元v3:于2018年推出,可提供高达420万亿次浮点运算能力,功耗大约450W

Inte Nervana NNP:于2019年推出,是一种神经网络处理器,是Intel在2016年以4亿美元收购Nervana后开发的,可提供119万亿次浮点运算能力,采用了优秀的散热设计以将功耗降低至大约200W

AI突破期——2020年至今

运算能力的显著提升,例如:

AMD MI200系列:于2021年推出,可提供383万亿次浮点运算能力,功耗为500W

Google TPU v4:于2021年推出,可提供275万亿次浮点运算能力,根据不同配置,功耗在200-250W之间

然而,英伟达无疑是最著名的AI处理器制造商,这家芯片制造商的股价在2024年上半年翻了一番,截至2024年6月英伟达成为了世界上最有价值的公司,并且其服务器系统规格的最新发展表明,每个服务器的最大功耗在增加,但每万亿次浮点运算的功耗在降低。

英伟达DGX H100(Grace Hopper)能在每万亿次浮点运算0.32kW的功率下运行,相较上一代(DGX A100)能够实现7倍的计算速度,但仅消耗其1.5倍的电力。近期宣布的英伟达Rubin的具体规格尚未公布,但其Blackwell DGX B200服务器系统将在Grace Hopper的基础上进一步提升,实现72万亿次浮点运算,但每万亿次浮点运算的功耗仅为0.2kW。然而,这仍然使每个服务器系统的功耗增加了40%,从Grace Hopper的每个700W,到Blackwell的1000W,意味着电源亟需进一步的升级迭代。

为应对AI带来的耗电量激增问题,数据中心电源的升级是解决这一能源危机的重要突破口。今天我们就来深入了解数据中心所用的电源规格、主流标准,并谈谈为什么第三代功率半导体——GaN和SiC是电源进化的关键。

数据中心在用什么电源?

人工智能和超大规模计算数据中心的电源有三种外形规格:

通用冗余电源的CRPS185、CRPS265,开放计算项目的OCP

宽度和高度尺寸相同:73.5mm x 40mm

长度不同:

- CRPS185 = 185mm

- CRPS265 = 265mm

- OCP电源长度可长达700mm

这些规格由包括戴尔、Facebook/Meta、Google、Intel和Microsoft在内的超大规模开放计算项目成员开发和定义。基于共同的标准,行业能够最大化兼容性,因此可进一步简化升级难度。

CRPS电源(左)和OCP电源(右)

每个CRPS185电源尺寸都是固定的为40 x 73.5 x 185mm。因此,AI服务器功率需求的增加就需要从功率密度下手。除了增加功率密度外,CRPS外形规格的发展路线图还强调了提高效率、可靠性和管理性的需要。

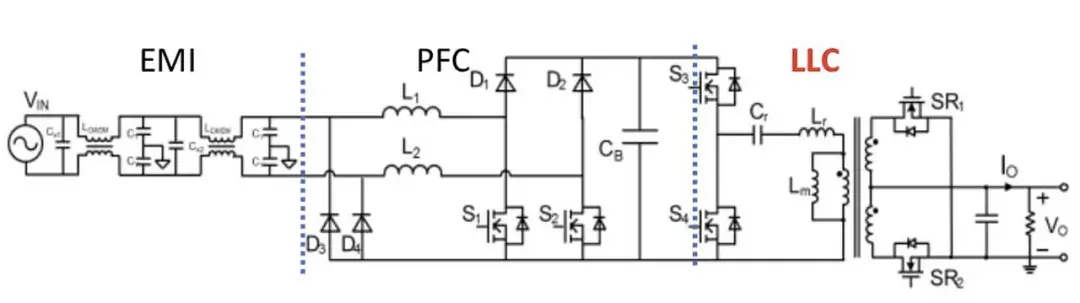

CRPS外形规格电源的电路图

功率密度的提高会带来多重挑战,比如电源需要更强的热管理,这增加了成本。

功率密度的增加的同时,提高电源的转换效率,可以减少了对热管理的需求。功率密度的提升可以通过提高开关频率来实现,但目前的功率密度已经达到了传统硅的物理性能极限。在高密度CRPS应用中,只有用氮化镓(GaN)器件替换硅MOSFET才能更高的开关频率,并允许使用平面变压器。

然而,分立的氮化镓场效应晶体管(FET)的栅极相对脆弱,容易造成桥臂上下管之间存在直通风险,因此使用GaN FET的解决方案可能会产生风险,而通过在与氮化镓FET相同的芯片上集成氮化镓栅极驱动电路可以很好解决这些问题。

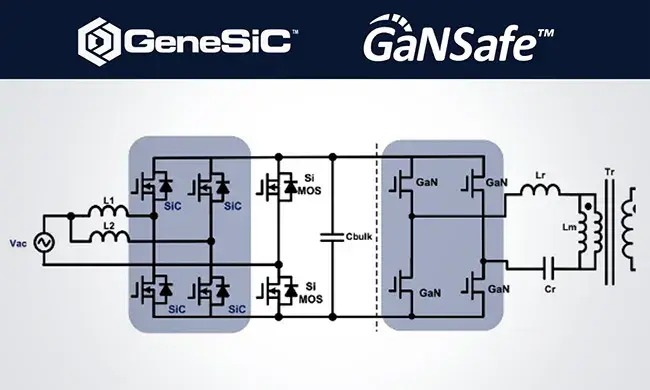

采用了纳微GaNSafe和GeneSiC器件的

AI数据中心CRPS电源电路图

80Plus电源标准

为了尽可能地减小电源损耗,行业已经建立了多种标准。其中电源(PSU)领域的关键标准是80 PLUS认证。

80 PLUS认证

80 PLUS认证是一个针对PSU制造商的自愿性计划,旨在鼓励制造商生产更高效的电源产品。

在最基本的层面上,它规定PSU在20%、50%和100%负载下,输入230V时,最低效率为80%。自2004年创立以来,随着技术的发展,又增加了五个额外的效率级别,以进一步提高PSU的效率。对于服务器电源,这些级别包括铜牌、银牌、金牌、白金牌和钛金牌,而欧盟对服务器电源的供应商的每个80 PLUS级别有更高的效率要求。自2012年以来,最高标准一直是钛金级钛金牌。

80 PLUS钛金

80 PLUS钛金标准要求,在输入230Vac时,PSU在10%负载下效率为90%,20%负载下效率为94%,在50%负载下为96%,在100%负载下为91%。

虽然欧盟并没有官方强制执行这一标准,但它已经将其生态设计指令与80 PLUS认证标准对齐,包括AI数据中心,法律上要求他们在欧盟领土内运营时,遵守这些生态设计指令。

超越钛金

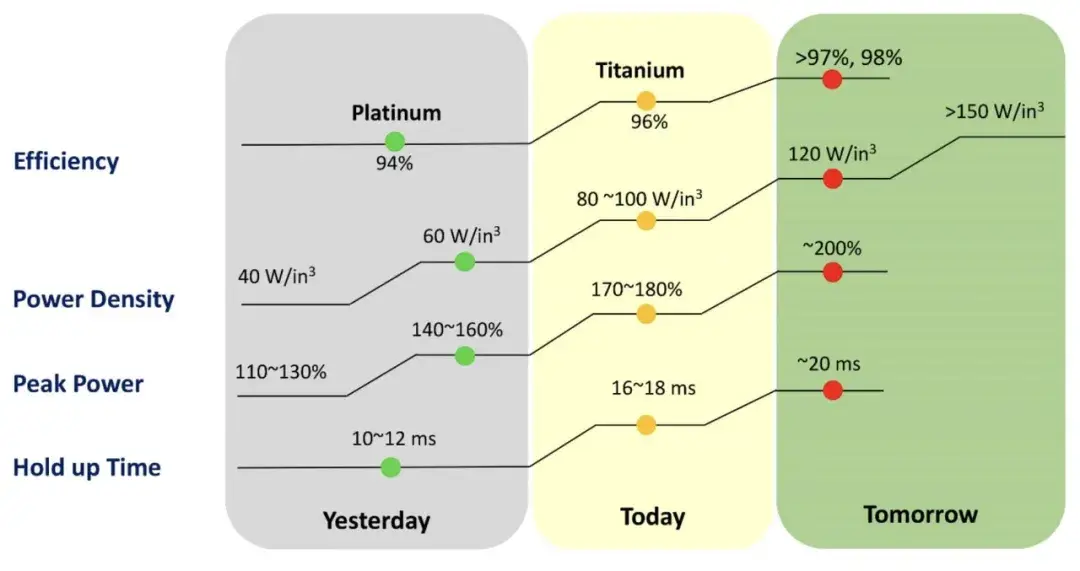

行业普遍认为,未来AI数据中心的电源(PSU)将需要符合下一代80 PLUS认证标准。

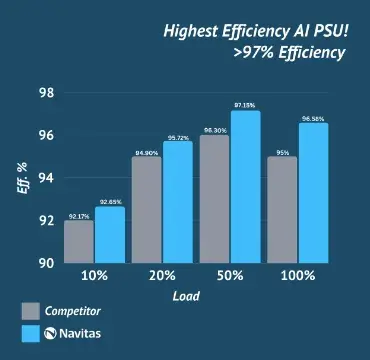

因此,我们预期在AI数据中心的电源,将被要求在50%负载下的效率超过97%,同时还需对功率密度、峰值功率和保持时间进行增进。

80Plus电源标准将会愈发严苛

硅 VS 宽禁带半导体

谁才是打造数据中心电源的顶流?

硅

数据中心服务器电源最常用的拓扑结构基于硅MOSFET打造,并具有升压功率因数校正(PFC)拓扑,随后是LLC谐振转换器。

与AI负载一同不断增长的功率需求,AI数据中心电源功率密度越来越高,对应的开关频率将需要进一步增加以减小无源器件包括磁件和电容的体积。

传统硅器件在高开关频率下表现出急剧增大的开关损耗,无法满足效率和热管理要求,这意味着传统硅器件在高功率密度AI数据中心电源方面的性能已达到极限。

宽禁带半导体在电源中的应用

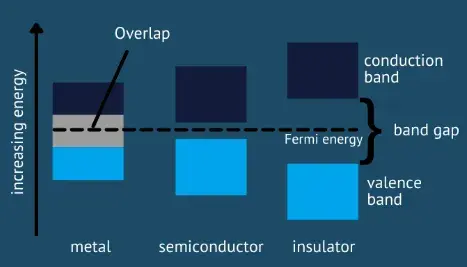

禁带是电子从其围绕核的轨道释放出来所需的能量。这直接决定了给定材料可承受的电场强度,更宽的禁带可以开发具有非常短或狭窄耗尽区的半导体材料。

这使得器件结构具有非常高的载流子密度,使得晶体管更小,电流路径更短,具有超低电阻和电容,以及比传统硅基半导体高几个数量级的开关速度。

禁带以eV为单位,其中硅的禁带为1.12 eV。

碳化硅

碳化硅(SiC)是一种以高热导率、高电场击穿强度和出色的热稳定性的卓越性能而闻名的化合物半导体,其禁带为2.26 eV。基于SiC打造的器件与硅基同类产品相比,可更高的温度和电压下运行,从而实现更高效的功率转换并减少能量损失。

SiC MOSFET和二极管能够实现更快的开关速度和更低的功率损耗,并提高系统的整体效率。尽管它们的物理和开关特性使它们更适合电动汽车、工业和可再生能源领域,但纳微通过将GeneSiC™功率器件以及氮化镓(GaN)功率芯片混合设计出的CRPS服务器电源参考设计,显著地提升了功率密度和效率。

氮化镓

氮化镓(GaN)具有3.39 eV的禁带和高电子迁移率,使得器件拥有更高的开关频率,并支持平面变压器的使用。

如前面所述,分立的GaN FETs具有相对脆弱的栅极,对于电源来说,为了防止臂上下管之间的直通,需要在与GaN FET相同的芯片上使用单片集成的GaN栅极驱动电路。

纳微的GaNSafe™具有高速保护功能,可在50ns实现超快的自主“检测到保护”,还具有2kV ESD功能。为防护异常的应用条件,GaNSafe还具有650V的连续和800V的瞬态电压等级。

GaN+SiC打造全球最高功率密度服务器电源

GaN和SiC的功率器件已经成功应用于CRPS外形规格的电源。比如纳微打造的3.2kW CRPS平台。

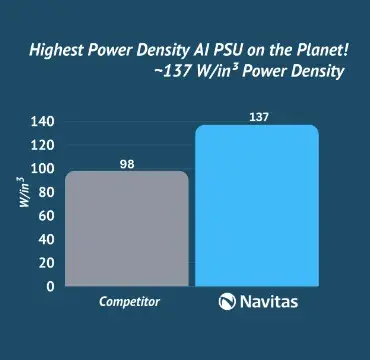

值得一提的是,纳微在2024年用GaNSafe和GeneSiC系列产品,发布了一款专属AI数据中心的服务器电源参考设计。这款54V AC-DC的AI数据中心服务器电源,基于CRPS185外形规格打造,与纳微此前发布的3.2kW CRPS电源相比,在相同尺寸下,具有4.5kW的输出功率,效率增至97%以上,功率密度从98W/in³增加到138W/in³。

纳微CRPS185 4.2kW电源技术详解

总结

在生成式AI全面铺开的前夜,数据中心的能源危机悄然而至。数据中心的耗电量的爆炸式增长,无论对其自身的发展或是碳净零的目标达成,都将带来严峻的挑战。如何成功突破能源困局,成为了数据中心的首要任务。

数据中心常用的CRPS和OCP固定外形电源,亟需在功率密度上大做文章,而现有的硅材料已经达到了物理极限,接力棒已经交到了下一代功率半导体——氮化镓和碳化硅手中。

由于氮化镓和碳化硅这两种第三代功率半导体,其宽禁带特性可带来更高的开关频率、更出色的热稳定性等性能优势,可助力服务器电源向更高效、更高功率密度和更低损耗的迈进。

https://www.chongdiantou.com/

https://www.chongdiantou.com/